研究生课程:模式识别与机器学习-第4章 特征选择和提取

《模式识别与机器学习》课程笔记:第4章 特征选择和提取

第4章 特征选择和提取

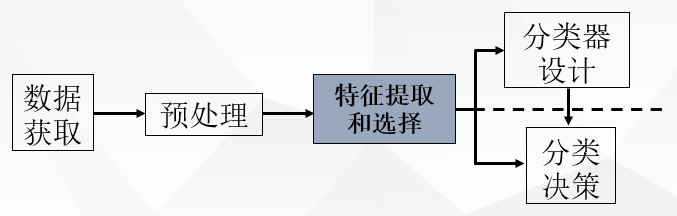

特征选择和提取是模式识别中的一个关键问题,前面讨论分类器设计的时候,一直假定已给出了特征向量维数确定的样本集,其中各样本的每一维都是该样本的一个特征;这些特征的选择是很重要的,它强烈地影响到分类器的设计及其性能;假若对不同的类别,这些特征的差别很大,则比较容易设计出具有较好性能的分类器。

例如,描述人可以用好多特征,如肤色,体重,身高等,但是如果要判断软件工程师,显然编程这个特征比较有判别性;如果要判断是不是篮球员,则体重、身高有很强的判别性。

特征选择和提取是构造模式识别系统时的一个重要课题。在很多实际问题中,往往不容易找到那些最重要的特征,或受客观条件的限制,不能对它们进行有效的测量;因此在测量时,由于人们心理上的作用,只要条件许可总希望把特征取得多一些;另外,由于客观上的需要,为了突出某些有用信息,抑制无用信息,有意加上一些比值、指数或对数等组合计算特征;如果将数目很多的测量值不做分析,全部直接用作分类特征,不但耗时,而且会影响到分类的效果,产生“特征维数灾难”问题。

为了设计出效果好的分类器,通常需要对原始的测量值集合进行分析,经过选择或变换处理,组成有效的识别特征;在保证一定分类精度的前提下,减少特征维数,即进行“降维”处理,使分类器实现快速、准确和高效的分类。为达到上述目的,关键是所提供的识别特征应具有很好的可分性,使分类器容易判别。为此,需对特征进行选择:

- 应去掉模棱两可、不易判别的特征;

- 所提供的特征不要重复,即去掉那些相关性强且没有增加更多分类信息的特征。

特征选择和提取这一任务应在设计分类器之前进行;

所谓特征选择,就是从

所谓特征提取,就是使

其目的都是为了在尽可能保留识别信息的前提下,降低特征空间的维数,以达到有效的分类效果。

模式类别可分性的测度

距离和散布矩阵:

- 点到点之间的距离:

,其中,

和

为

维向量, 其第

个分量分别是

和

- 点到点集之间的距离:点

到点集

之间的距离为

类内距离:

类内散布矩阵:考虑一类内模式点集

对属于同一类的模式样本,类内散布矩阵表示各样本点围绕其均值周围的散布情况。

在考虑有两个以上的类别,如集合

为简化起见,常用两类样本各自质心间的距离作为类间距离,并假设两类样本出现的概率相等,则

其中

两类模式的类间散布矩阵:

对三个以上的类别,类间散布矩阵常写成

多类情况的类内散布矩阵可写成各类的类内散布矩阵的先验概率的加权和,即

有时,用多类模式总体分布的散布矩阵来反映其可分性,即:

特征选择

设有

从

对于独立特征的选择准则:类别可分性准则应具有这样的特点,即不同类别模式特征的均值向量之间的距离应最大,而属于同一类的模式特征,其方差之和应最小。假设各原始特征测量值是统计独立的,此时,只需对训练样本的

对于

上述基于距离测度的可分性准则,其适用范围与模式特征的分布有关。假若类概率密度函数不是或不近似正态分布,均值和方差就不足以用来估计类别的可分性,此时该准则函数不完全适用。

一般特征的散布矩阵准则:

- 类内:

- 类间:

直观上,类间离散度越大且类内离散度越小,则可分性越好。因此,可推导出散布矩阵准则采用如下形式:

- 行列式形式:

- 迹形式:

其中,

离散K-L变换(Karhunen-Loeve变换(卡洛南-洛伊变换))

前面讨论的特征选择是在一定准则下,从

K-L变换就是一种适用于任意概率密度函数的正交变换。

离散的有限K-L展开

离散的有限K-L展开式的形式:

设一连续的随机实函数

将上式写成离散的正交函数形式,使连续随机函数

写成向量形式:

将展开式写成离散形式:

它将

对各个模式类别,正交函数都是相同的,但其展开系数向量

K-L展开式的根本性质是将随机向量

正交向量集

设随机向量

因为

K-L展开式系数的计算步骤:

- 求随机向量

的自相关矩阵:

- 求出矩阵

的特征值

和对应的特征向量

,

,得矩阵:

- 计算展开式系数:

按K-L展开式选择特征

K-L展开式用于特征选择相当于一种线性变换。若从

结论

从K-L展开式的性质和按最小均方差的准则来选择特征,应使

将K-L展开式系数

K-L变换是在均方误差最小的意义下获得数据压缩(降维)的最佳变换,且不受模式分布的限制。对于一种类别的模式特征提取,它不存在特征分类问题,只是实现用低维的

通过K-L变换能获得互不相关的新特征。若采用较大特征值对应的特征向量组成变换矩阵,则能对应地保留原模式中方差最大的特征成分,所以K-L变换起到了减小相关性、突出差异性的效果。在此情况下,K-L变换也称为主成分变换(PCA变换)。

需要指出的是,采用K-L变换作为模式分类的特征提取时,要特别注意保留不同类别的模式分类鉴别信息,仅单纯考虑尽可能代表原来模式的主成分,有时并不一定有利于分类的鉴别。