研究生课程:机器学习-第7章 降维与特征选择

《机器学习》课程笔记:第7章 降维与特征选择

第7章 降维与特征选择

概述

机器学习算法的有效性和计算复杂度是敏感于数据的特征表达和维度。

特征降维的意义:

数据压缩:简化数据表示,加快数据通信传输、节省存储资源、…

学习算法效率:

- 计算上,简化计算,加快速度

- 性能上,提升精确度

- 可理解性,发现数据的潜在本质特征

特征选择:从D个特征中选择d个,来表达模式

特征提取:采用特征变换的方法,生成d个新的特征

特征选择

特征选择框架

特征选择问题:从D维特征中选择d维(d<D)特征子集

- 使数据的压缩率高

- 使学习机预测性能最佳

- 使学习机学习速度加快

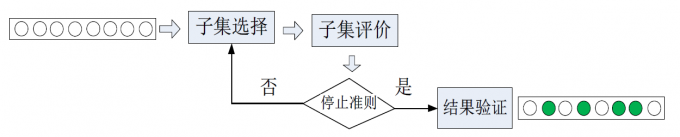

特征选择的处理过程:

特征子集生成

特征子集生成问题:D维特征中,选择d维(d<D)特征子集,子集个数为

- 穷举(最优子集搜索):计算特征的所有可能组合,并逐一评价。

- 单独最优特征组合:对每个特征分别评估,找前d个单独最优特征。优点:算法简单,缺点:没有考虑特征之间的关系,存在特征冗余

- SFS(Sequential forward selection, 前向序贯):每次加入一个特征,该特征使得新的特征组合最优。

- GSFS (广义SFS):每次加入k个特征,使加入特征后的组合最优。

- SBS(Sequential backward selection, 后向序贯):每次减掉一个特征,使剩余特征组合最优。

- GSBS(广义SBS):每次减k个特征,使剩余特征组合最优。

- L-R 法(增加L个,减R个)每次增加L个再减R个(L > R),或减R个增加L个(L < R)

- 广义的L-R(ZL , ZR):增L和减R分Z步进行

特征评价准则

- 可分性度量:在选择的特征集下,采用类别可分性的程度,评价特征选择的好与坏。常用于Filter框架下。

- 学习算法精度的度量:在选择的特征集下,通过学习算法的精确度,评价特征选择的好与坏。常用于wrapper框架下。

基于距离的可分性判据:

通常依赖于类内类间的距离度量,前提是数据具有类别标签。可分性评估是在选择的特征子集维度上计算数据统计量。

距离的可分性判据的特点:

- 容易理解和实现

- 与错误率无直接关系,不敏感于数据交叠情况

- 常用于Filter特征选择框架下

基于概率分布的可分性判据:从类别概率密度的角度,讨论两个类别的交叠程度

常见的概率距离准则:

熵可分性判据:

特征选择方法

Filter 方法:

不依赖于学习算法(如分类器)的结果,直接由数据构建评估函数,对选择的特征子集进行评估。

通常方法:根据特征评价准则进行评估,选择最优的特征子集。

评价准则:距离准则、概率可分、熵可分准则。

优点:计算复杂度低,效率高。

缺点:选择的特征之间存在冗余信息。

Wrapper 方法:

原理:通过学习算法(如分类器),对选择的特征子集进行评估。

优点:选择的特征可以支持学习算法。

缺点:算法的计算复杂度高。

Embedded 方法:

原理:特征选择过程在学习算法中完成,目标是完成学习过程。

特点:不是专门的特征选择过程

缺点:计算复杂度高。

特征提取

优点:

- 数据更紧致的压缩

- 优化预测性能

- 加快学习速度

不同的应用问题会有不同的特征提取研究问题

线性变换

特征提取目标:学习变换矩阵

给定

两种降维表示途径:

- 投影:

- 矩阵分解:低秩表示:

主成分分析PCA

目标函数:均方误差最小原则(求最优重构子空间)

最小误差等价于最大投影

求解目标函数:

特征值的意义:样本在w方向的投影平均值(或和)最大

PCA算法流程:

- 标准化样本

- 求样本的协方差矩阵

特征值,并降排序

对应非零特征向量

- 变换矩阵

- 降维表示

线性鉴别分析LDA

PCA能保证类别区分的有效性,LDA特征的优点:类内最小、类间最大。

特征方向的提取:

非线性变换

核主成分分析KPCA

- 求核矩阵

的特征值,对应特征向量

的问题:

- 核矩阵

的特征值降序

,前

个特征值对应特征向量

- 高维空间中的投影方向$w_i=\Phi \boldsymbol{\alpha}_i

\boldsymbol{\Lambda}=\left(\boldsymbol{\alpha}_1, \boldsymbol{\alpha}_2, \ldots, \boldsymbol{\alpha}_d\right)

W=\Phi \boldsymbol{\Lambda}$

- 降维表示

- 训练集低维表示:

- 新样本

的低维表示:

- 其中

- 训练集低维表示:

局部线性变换LLE

LLE方法是一种流形学习,保持样本间的局部线性关系,整体实现非线性映射。

非负矩阵分解

基本思想:通过矩阵分解,进行数据降维;分解后的矩阵为非负矩阵

不同的目标函数情况:

- 范数误差最小

- KL误差